Foi publicada no último domingo uma pesquisa realizada pela agência Ideia, em colaboração com o Brazil Forum UK, sobre a percepção dos brasileiros e brasileiras em torno de tecnologias de inteligência artificial. O questionário contou com uma série de perguntas que vão desde o sentimento dos cidadãos em relação à IA até sua percepção e nível de conforto com o uso da tecnologia para determinados fins. Dentre os vários destaques, porém, uma aparente contradição joga luz importante sobre onde o debate ainda precisa ser aprofundado.

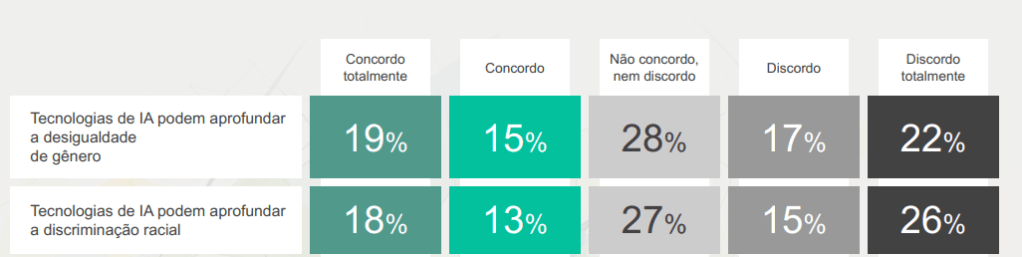

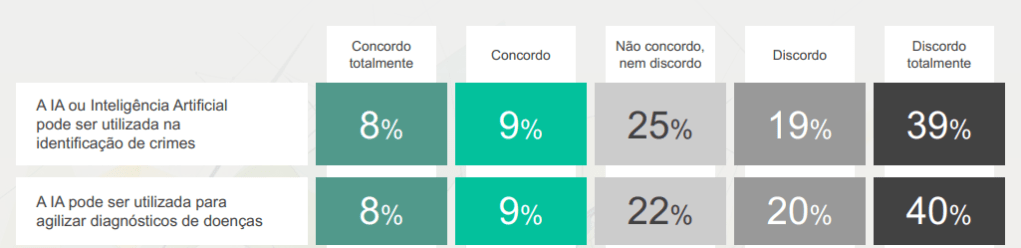

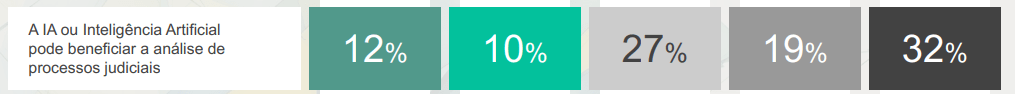

Apesar de, em um primeiro momento, os respondentes terem afirmado em sua maioria serem neutros ou discordarem que a IA poderia aprofundar a desigualdade de gênero e a discriminação racial, os dados da pesquisa apontam para uma discordância massiva em relação ao uso dessa tecnologia justamente em casos em que ela pode reconhecidamente potencializar discriminações. O uso de IA na saúde, por exemplo, como para agilizar o diagnóstico de doenças, foi visto negativamente por, pelo menos, 60% dos entrevistados. Da mesma forma, o uso de inteligência artificial para a identificação de crimes e para análise de processos judiciais teve forte reprovação por 58% e 51% dos entrevistados, respectivamente.

Ocorre que todas essas tecnologias já foram apontadas por diferentes estudos como capazes de reproduzir discriminações estruturais. Na saúde, um estudo sobre algoritmos que eram utilizados para avaliar a necessidade de cuidados médicos descobriu que eles estavam atribuindo a mesma faixa de risco para pacientes negros que estavam muito mais debilitados do que pacientes brancos [1]. A pesquisa, realizada nos Estados Unidos, demonstrou que os resultados eram enviesados tanto pela utilização do histórico de gastos com pacientes como variável, o que reforçava a desigualdade no acesso a recursos pela população negra no país, como também possíveis decisões racistas de médicos que optaram por destinar menos recursos a essas pessoas [2]. Este caso não é isolado e se soma a outros em que sistemas de IA na saúde potencializam discriminações, como também os algoritmos de diagnóstico de câncer de pele que têm menos efetividade sobre peles negras [3].

No sistema penal e judiciário, as falhas se repetem. A utilização de sistemas de policiamento preditivo já se demonstrou racista mesmo com diferentes bases de dados para treinamento. Quando treinados em dados policiais, como detenções, o algoritmo reforçava não somente práticas discriminatórias presentes nas abordagens, como até mesmo dados falsificados propositalmente pelos agentes em razão da pressão para reduzir taxas de criminalidade [4]. Quando treinados em dados sobre número de prisões, o algoritmo reproduzia a tendência policial de prender mais pessoas em bairros negros e minoritários e, quando treinados sobre os relatos de vítimas de crime (que, em tese, não conteriam os vieses preconceituosos da polícia), o problema era que também havia a intensificação de visões distorcidas apresentadas por essa fonte, como, por exemplo, o fato de que havia mais chances de uma pessoa branca mais rica denunciar uma pessoa negra mais pobre do que o contrário [5].

Por outro lado, no sistema judicial, a história do sistema COMPAS se tornou representativa pelo seu impacto negativo. A ferramenta, que deveria servir para auxiliar juízes na concessão de benefícios judiciais, como liberdade condicional, por exemplo, estava na verdade gerando conclusões mais prejudiciais a minorias étnicas. Mesmo sem considerar especificamente o quesito racial, e ainda que haja disputas de narrativas sobre suas conclusões [6], é fato que o sistema considerava informações que reiteravam a discriminação racial presente no sistema penal dos Estados Unidos [7].

Nesse sentido, ainda que a pesquisa realizada pelo Brazil Forum UK com a agência Ideia tenha indicado discordância em relação à possibilidade da IA potencializar desigualdades e discriminações raciais, o fato de também haver resistência à adoção da tecnologia em áreas críticas, como saúde, justiça e polícia, demonstra uma questão paradoxal. A falta de confiança é justamente em casos onde a discriminação pode ser facilmente perpetuada, demonstrando uma aprofundada percepção pessimista em torno do que poderiam ser pontos positivos da IA. No entanto, isso parece apontar para uma desconexão entre os dois lados, ou seja, uma aparente falta de conhecimento sobre o potencial discriminatório de sistemas algorítmicos.

O tecnosolucionismo e a falácia da tecnologia neutra parecem ainda alimentar fortemente a crença de que a IA é incapaz de ser preconceituosa, na medida em que se trataria de um sistema “puramente matemático” e, como tal, objetivo. Ocorre que enquanto uma tecnologia que é inserida em um contexto social, do qual ela também obtém seus dados para treinamento, sistemas de inteligência artificial tendem a repetir toda forma de discriminação presente na realidade que a informa e sobre a qual ela age, principalmente se não houver medidas de mitigação efetivamente comprometidas com a eliminação de vieses discriminatórios.

Avaliações de impacto algorítmico, gradação de riscos, justificação para implementação de sistemas algorítmicos de alto risco, auditorias externas e independentes, dentre outros, são apenas algumas das medidas que podem ser listadas. isso tudo pois o problema não são apenas os dados que alimentam esses sistemas, mas, sim, toda a cadeia produtiva que pode ser caminho para a incorporação de vieses discriminatórios, de modo que uma estrutura holística para enfrentar esse problema é ainda mais necessária.

Em um cenário de disputa discursiva para a elaboração de um marco regulatório da IA no país, os dados da pesquisa demonstram a importância de um diálogo com a população que seja capaz de traduzir os reais riscos da tecnologia de forma simples e acessível. Provar que uma regulação baseada em direitos e riscos não impedirá a inovação do setor tecnológico no Brasil só será possível quando a população compreender e reconhecer que os possíveis danos da IA já estão ocorrendo e pessoas já estão sendo prejudicadas, de modo que uma regulação robusta e, ao mesmo tempo, flexível, é necessária para evitar a perpetuação de preconceitos sobre comunidades já historicamente marginalizadas.

[1] OBERMEYER, Ziad et al. Dissecting racial bias in an algorithm used to manage the health of populations. Science, v. 366, n. 6464, 25 out. 2019. Disponível em: https://www.science.org/doi/10.1126/science.aax2342. Acesso em: 22 jun. 2024.

[2] SILVA, Tarcízio; RODRIGUES, Fernanda. Sem ajustes, inteligência artificial pode aprofundar desigualdades na saúde. Estadão, 22 abr. 2024. Disponível em: https://www.estadao.com.br/saude/sem-ajustes-inteligencia-artificial-pode-aprofundar-desigualdades-na-saude/. Acesso em: 22 jun. 2024.

[3] DAVIS, Nicola. AI skin cancer diagnoses risk being less accurate for dark skin – study. The Gaurdian, 9 nov. 2021. Disponível em: https://www.theguardian.com/society/2021/nov/09/ai-skin-cancer-diagnoses-risk-being-less-accurate-for-dark-skin-study. Acesso em: 22 jun. 2024.

[4] HAO, Karen. Police across the US are training crime-predicting AIs on falsified data. MIT Technology Review, 13 fev. 2019. Disponível em: https://www.technologyreview.com/2019/02/13/137444/predictive-policing-algorithms-ai-crime-dirty-data/. Acesso em: 22 jun. 2024.

[5] CÉU, Will Douglas. Predictive policing is still racist—whatever data it uses. MIT Technology Review, 5 fev. 2021. Disponível em: https://www.technologyreview.com/2021/02/05/1017560/predictive-policing-racist-algorithmic-bias-data-crime-predpol/. Acesso em: 22 jun. 2024.

[6] MAYBIN, Simon. Sistema de algoritmo que determina pena de condenados cria polêmica nos EUA. BBC News, 31 out. 2016. Disponível em: https://www.bbc.com/portuguese/brasil-37677421. Acesso em: 22 jun. 2024.

[7] LARSON, Jeff. How We Analyzed the COMPAS Recidivism Algorithm. ProPublica, 23 mai. 2016. Disponível em: https://www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm. Acesso em: 22 jun. 2024.

Deixe um comentário